[DDC]Deep Domain Confusion: Maximizing for Domain Invariance

DDC针对预训练的AlexNet(8层)网络,在第7层(也就是feature层,softmax的上一层)加入了MMD距离来减小source和target之间的差异。这个方法简称为DDC。

DDC针对预训练的AlexNet(8层)网络,在第7层(也就是feature层,softmax的上一层)加入了MMD距离来减小source和target之间的差异。这个方法简称为DDC。

Abstract

最近的报告表明,在大规模数据集上训练的通用监督深度CNN模型减少了,但没有消除标准benchmark上的数据集的bias。在一个新的领域中对深度模型进行微调(Fine-tuning deep models )可能需要大量的数据,而对于许多应用来说,这些数据是不可用的。我们提出一种新的CNN架构,它引入了一个适应层(adaptation layer )和一个额外的domain confusion loss,以学习一个语义上有意义和域不变的表示。此外,我们还展示了一个domain confusion metric 可以用于模型选择,以确定自适应层的维数和该层在CNN体系结构中的最佳位置。我们提出的适应方法提供了经验的表现,这超过了以前发表的标准benchmark视觉的域适应任务的结果。

1. Introduction

调整深度模型的传统方法是微调(fine-tuning),在少量标记的目标数据上直接微调深度网络的参数是有问题的。不过预先训练的深度模型(预训练模型)在新域中表现良好。

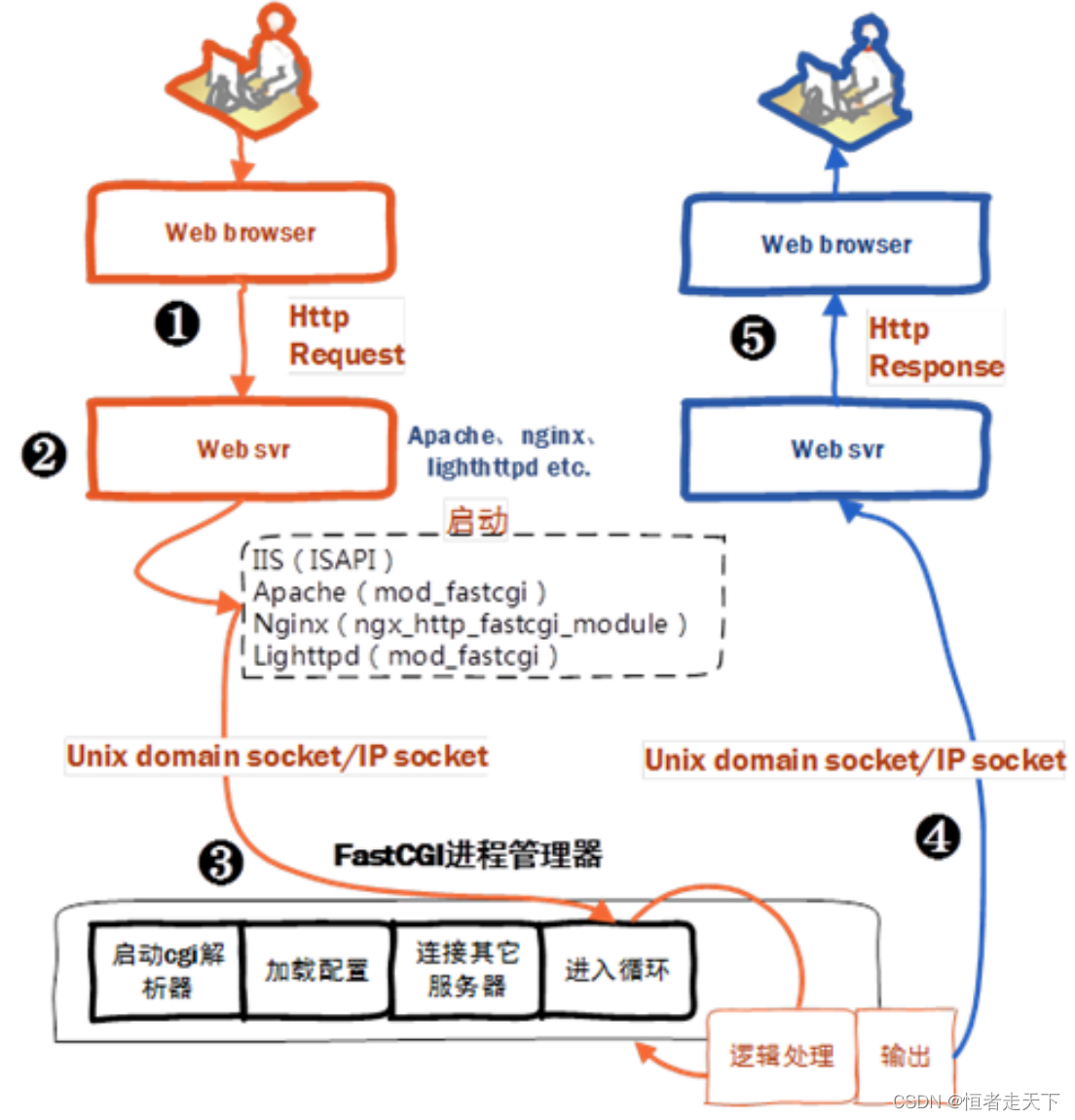

我们提出了一种新的CNN架构,如图1所示,该架构使用了一个自适应层(adaptation layer)和一个基于最大平均偏差(MMD,maximum mean discrepancy)[6]的domain confusion loss来自动学习一个联合训练的表示来优化分类和域不变性。我们展示了我们的domain confusion metric既可以用来选择适应层的维数,也可以在一个预先训练好的CNN体系结构中为一个新的适应层选择一个有效的位置,还可以对表示形式进行微调。

我们的结构既可以解决supervised adaptation(当有少量目标标记数据可用时)问题,也可以解决unsupervised adaptation(当没有标记目标训练数据可用时)问题。

classification loss as well as domain invariance. The model

can be trained for supervised adaptation, when there is a

small amount of target labels available, or unsupervised

adaptation, when no target labels are available. We introduce

domain invariance through domain confusion guided

selection of the depth and width of the adaptation layer, as

well as an additional domain loss term during fine-tuning

that directly minimizes the distance between source and target

representations.

2. Related work

3. Training CNN-based domain invariant representations

We introduce a new CNN architecture which we use to learn a visual representation that is both domain invariant and which offers strong semantic separation. 经过训练的CNN可以通过微调来适应新的任务。然而,在域适应场景,在目标域T几乎没有标记的训练数据,所以我们不能直接调整网络。相反,我们将使用的数据相关但不同的源域S,在这个源域中有更多可用的标签数据。

只使用源域的数据直接训练一个分类器常常会导致过度拟合源域的分布,而在目标域中进行识别时又会导致测试时性能下降。如果我们能够学习一种最小化源域分布和目标域分布之间距离的表示,那么我们就可以在源域上标记的数据上训练一个分类器,并将其直接应用到目标域中,同时精度损失最小。

为了使这个距离最小化,我们考虑了标准分布距离度量,即最大平均偏差(MMD)[6]。这个距离是计算对一个特定的表示, 。在我们的任务中,我们定义了一个表征,

。在我们的任务中,我们定义了一个表征, ,即表示在源域的数据点,

,即表示在源域的数据点, ,和目标数据点

,和目标数据点 。然后计算这个距离的经验公式近似如下:

。然后计算这个距离的经验公式近似如下:

如图2所示,我们不仅想要最小化域之间的距离(或者最大化domain confusion),还想要得到有助于训练强分类器的表示。这样的表示将使我们能够学习易于跨域转换transfer的强分类器。满足这两项要求的一个办法是尽量减少损失:

![]()

其中 表示在可用的带标签数据

表示在可用的带标签数据 上的分类损失,以及所带的真实ground truth标签

上的分类损失,以及所带的真实ground truth标签,

表示源域数据

表示源域数据 与目标数据

与目标数据 之间的距离。参数

之间的距离。参数 表示我们confuse the domain的程度。

表示我们confuse the domain的程度。

4. Evaluation

4.1. Evaluating adaptation layer placement

我们首先评估我们的特征表示选择策略。利用一个预先训练好的卷积神经网络,利用每一个全连接层的表示形式,从源域数据和目标域数据中提取特征,然后可以在每一层中计算源域和目标域之间的MMD。由于MMD越低,表示的域不变程度越高,因此我们期望MMD越低越好,MMD越低其表示自适应后性能越好。fc7是性能最好的层,fc6是性能最差的层,因此,后续在fc7之后添加了adaptation layer 。[作为以后设计结构的时候层的选择的参考]

4.2. Choosing the adaptation layer dimension

因此综合考虑选择256维。

4.3. Fine-tuning with domain confusion regularization

4.4. Historical Progress on the Office Dataset

5. Conclusion

论文提出的架构一部分是希望source domain 和 target domain 通过特征提取的网络可以得到其不变的特征,所以设计的domain loss 应该是让其提取的特征非常接近。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)